大規模言語モデルの進化とビジネスへの応用

デジタルトランスフォーメーション(DX)の波がビジネスのあらゆる領域に求められる中、AIを用いた新たな技術の導入と適用は、企業競争力を高めるために不可欠なものとなっています。近年、AIを用いた自然言語処理技術はその一翼を担い、飛躍的な進化を遂げています。特に、大規模言語モデル(Large Language Model:LLM)の台頭は、ビジネス領域における多岐にわたる応用が可能となり、企業のDX戦略において革命的な変革の兆しを見せています。

このLLMの進化は、顧客対応から内部業務の自動化、情報解析まで、ビジネスの様々なフェーズでの利用が期待されています。従来の手法では難しかった大量のテキストデータからの知識抽出や、高度な質問応答システムの構築が、LLMの力を借りて現実のものとなっています。このような技術的進歩は、企業のDX化を加速し、新しいビジネスモデルや価値提供の機会を生み出す可能性があります。

大規模言語モデル(LLM)のビジネス応用例として下記が挙げられます。

- カスタマーサポート

従来は顧客の問い合わせへの対応がスタッフによる手動で行われていたが、LLMの導入により一般的な質問への対応が自動化され、混雑時や営業時間外でも対応が可能となり、人件費の削減やリソースの有効活用が期待されます。 - コンテンツ作成

従来は専門的なライターの雇用や委託でのコストと時間がかかっていたが、LLMを利用することでキーワードを元に迅速に文章を生成できるようになり、市場の動きに素早く対応するコンテンツ制作が効率化されます。 - 教育分野

従来は教員のTA(Teaching Assitant)が対応するために準備や実施の手間を必要としたが、LLMの導入により自動的なフィードバックの提供が効率化され、より多くの学生へのサポートが可能となります。 - リサーチアシスタント

手動での情報収集やサマリー作成に時間とコストがかかっていたが、LLMの利用により関連する情報の迅速な取得や論文のサマリー作成が効率化されます。 - エンターテインメント

ストーリーや対話の内容の作成に専門の作家への依頼が必要であり高いコストと時間がかかっていたが、LLMの導入で効率的なコンテンツ製作が可能となり、生産コストが削減されます。

大規模言語モデルの限界

LLMは、学習した大量のデータに基づく事前知識を活用することで、これらのユースケースにおいて高いパフォーマンスを発揮してタスクを効率化することが期待できます。しかし、その一方で、社内固有のデータ等、未学習の独自データ情報に対する知識を必要とする特定のビジネスニーズには完全に応えられない場合があります。

例えば、ChatGPTに弊社社長について問うと、実在しない社長名が回答となりました(GPT4を利用。ChatGPT September 25 Version)。

これはLLMにおける、ハルシネーション(Hallucination)、と呼ばれる現象として知られています。ハルシネーションは、LLMが実際には存在しない情報や事実を生成することを指し、ビジネスの現場におけるLLM利用において発生が避けられないものとして対応が求められる課題となっています。

ハルシネーションの特徴をまとめると、次のようになります。

- 学習データの影響

LLMは、訓練時に提供されたデータに基づいてのみ回答を試みることができます。未学習の内容については、分からない・知らないと回答を生成する場合もありますが、誤った情報や似たような情報に基づいた不正確な情報を生成して回答してしまうリスクがあります。 - 一般的な知識の過度な依存

LLMは多岐にわたるトピックに対して知識を持っていますが、具体的な証拠や情報源を明示せずに回答することがあります。これは、一般的な知識に基づく回答の傾向が強いためです。 - 情報の信頼性

ユーザーからの質問に対して、LLMはもっとも適切と思われる回答を生成しますが、そのすべてが正確であるとは限りません。

ビジネスの現場でのLLM活用においては、LLMが対応できる機能限界を十分に考慮し、モデルの回答の有効性や情報更新の取り扱いを適切に評価する必要があります。

LLMを独自データで活用するためのアプローチ

このような課題に対して、LLMが事前に学習していない情報から回答を生成できるようにするためのアプローチとして、モデルを学習する手法である、教師ありFine-Tuning や Reinforcement Learning from Human Feedback (RLHF)、また、LLM外部に備えたデータを参照して回答を生成する、Retrieval-Augmented Generation (RAG) 、等があります。

- 教師ありFine-Tuning(Supervised Fine-Tuning:SFT)

タスク固有のデータセットを利用してモデルを調整する方法です。このアプローチの最大の利点は、そのタスクに特化したデータに基づいてモデルを最適化することができる点にあります。また、実装や適用が比較的容易であり、短時間で高品質のモデルを取得することが可能です。一方で、モデル学習のためのGPUリソースが必要であり、良質なタスク固有のデータセットの必要性や、訓練データにしか存在しない特定のパターンに過度に適合する可能性があります。 - Reinforcement Learning from Human Feedback (RLHF):

人間のフィードバックを基にモデルの学習を進めるアプローチです。微妙なニュアンスや状況にも柔軟に対応することができるのが大きな魅力です。加えて、モデルが犯す特定のエラーを修正しやすい点も評価されています。しかし、高品質のフィードバックを大量に取得するための人材が必要であり、また、時間的、費用的にもコストを要する課題が存在します。 - Retrieval-Augmented Generation (RAG)

既存の知識ベースやデータベースからの情報を活用して回答を生成する手法です。これにより、多様な質問や未知のトピックにも対応することが期待されています。情報検索と文書生成を統合することで、豊富なコンテキストを持った回答が可能となります。一方、情報検索と生成の両方のコンポーネントを最適化する必要があるため設計と実装の複雑さが増すが、それを支援する外部ツールも複数利用可能である。

RAGを使用したLLMでの独自データの活用

以下では、モデルの学習をすることなしに、LLMで独自データの活用が可能なRAG (Retrieval-Augmented Generation) について説明します。

RAGは、2020年に当時のFacebook社が発表した自然言語処理(NLP)モデルの性能向上手法です。事前学習したモデルの知識を、モデル外部に備えた知識データを用いて補完する手法です。RAGをLLMベースの質問応答システムに導入することで、モデルが外部に備えた最新かつ信頼性のある情報にアクセスでき、また、ユーザーがモデルの情報源にアクセスして正確性を確認することができます。これにより、モデルが生成する回答の情報が信頼できるものであることを保証できます。

RAGは、情報の取得(Retriever)、情報の組み合わせ・調整(Augmentation)、そしてテキスト生成(Generator)の3つの主要な要素で構成されます。

- Retriever:大量の情報から最も関連性の高いデータを効率的に抽出する役割を果たします。

- Argumentation:取得した情報とユーザーからのクエリを調和させ、適切な入力を形成します。

- Generator:入力に基づき、文脈に合わせたテキストを生成します。

RAGを用いることで、検索フェーズでは、ユーザーからの質問やプロンプトに関連した情報の断片を効率的に探し出し、検索内容に応じてモデルが事前学習したオープンなデータ、および、独自データのようなクローズドなデータを情報源として、回答を生成します。

実際にRAGの機能を実装するためには、LLMとは別に専用のライブラリ・フレームワークを使用します。このようなライブラリの一例として、下記があります。

- LangChain(https://www.langchain.com/)

言語モデルを活用したアプリケーション開発のフレームワークです。文脈認識機能や推論能力を持ち、モジュールコンポーネントを提供しています。言語モデル(LLM)と文章ソースとを繋ぐための様々なチェーンを使用することで簡単に利用でき、複雑なアプリケーションには既存のチェーンをカスタマイズするためのコンポーネントが利用できます。 - LlamaIndex(https://www.llamaindex.ai/)

LLMに専門的なデータやプライベートデータを取り込んでアプリケーションを構築するためのデータフレームワークです。LlamaIndexを用いることで、大量のデータで事前学習されたLLMに、分散保存された特定領域やプライベートなデータを取り入れることができます。 - haystack(https://haystack.deepset.ai/)

検索のさまざまなユースケースに対して、LLMを使用して強力で本番環境向けのパイプラインを構築するためのフレームワークです。RAGや質問応答、セマンティック検索など、Haystackの先進的なLLMやNLPモデルを利用して、ユーザーが自然言語でクエリを行えるカスタム検索体験を提供できます。

各ライブラリには提供機能の差異があります。ライブラリの選定には、それぞれのWEBサイト等を確認して必要な機能の有無を確認して下さい。また、下記の観点も考慮して下さい。

- 使いやすさ:アクセスが容易で、導入が簡単なフレームワークが望ましい。

- 柔軟性:独自の要件に合わせてカスタマイズが可能なフレームワークが効果的です。

- パフォーマンス:大量のデータの処理能力が確保されていること。

- 拡張性:将来の拡大や変更にも対応できるフレームワークが必要です。

- サポート:サポート体制や活発なコミュニティが存在するフレームワークを選択することで、トラブルシューティングや情報交換が容易になります。

<画像>

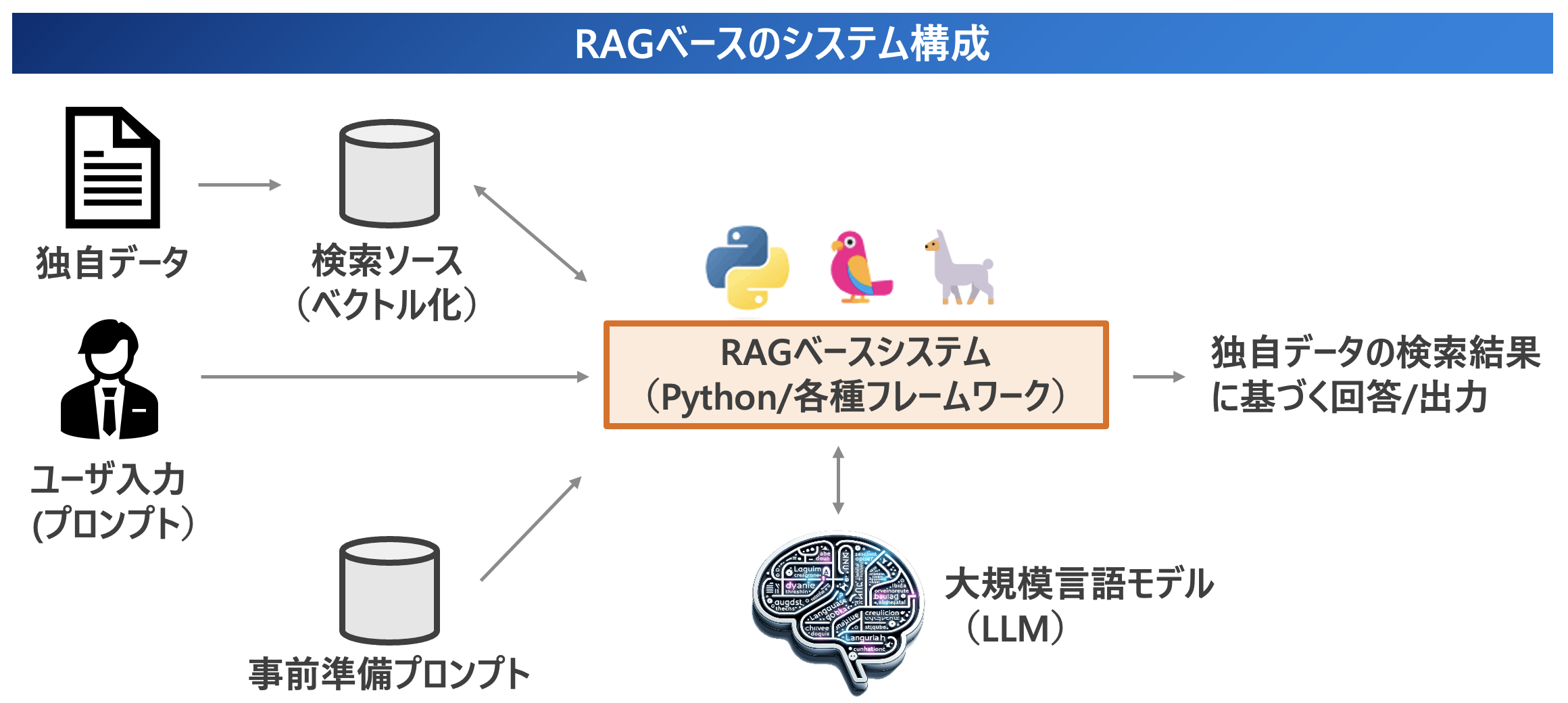

下記にRAGベースの典型的なシステム構成を示します。アラヤでは Python をベースに LangChain や LlamaIndex を用いて、LLMで独自データを活用した様々なユースケースにおけるシステム構築に関するコンサルティング・提案・開発を行っています。

4. まとめと将来展望

ChatGPTなどの大規模言語モデルの性能向上とその応用の広がりを背景に、RAGはビジネスアプリケーションにおいても大きな価値をもたらす可能性があります。RAGベースのLLMシステムにより、社内データ等の独自データにおいても具体的な事実に基づいた迅速で正確な応答を生成することができ、カスタマーサポートやFAQの自動応答など、さまざまな業務プロセスの効率化への活用が期待できます。

アラヤでの独自データを用いてLLMを活用したシステム開発を検討されている方は、ぜひお気軽にアラヤへお問合せ下さい。詳細はこちらのページをご確認下さい。

お問い合わせ

お問い合わせ